안녕하세요. ManVSCloud 김수현입니다.

오늘은 네이버 클라우드에서 Server 사용 시 Windows 환경에서 2TB 이상 파티션을 사용하는 방법에 대해 알아보도록 하겠습니다.

Environment and Description

? 사용된 OS : win-2016-64-en

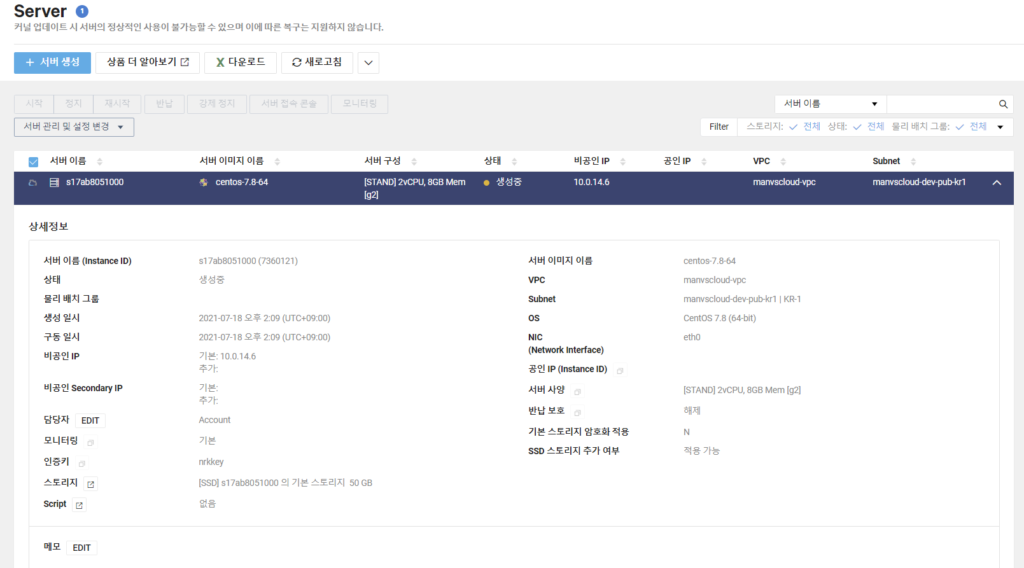

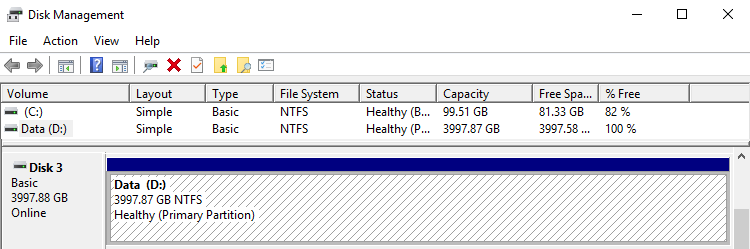

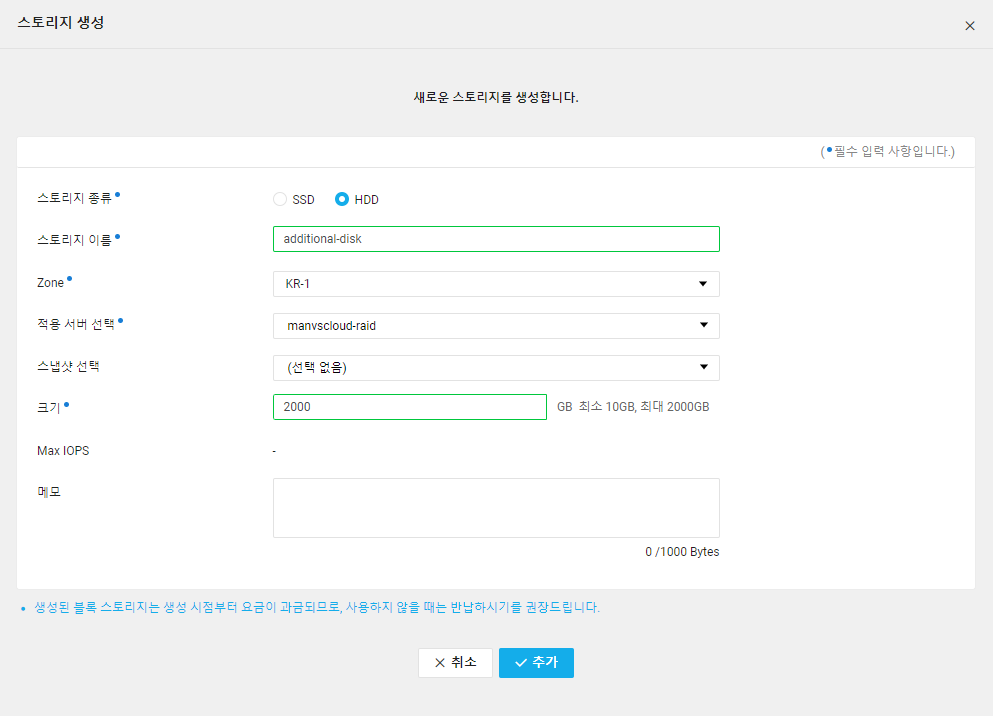

Linux 편에서도 설명했듯 네이버 클라우드에서 스토리지를 추가하여 생성할 때 최대 볼륨 크기는 2000GB로 제한되어 있습니다.

Linux 환경에서는 LVM(Logical Volume Manager)을 이용하여 최대 용량을 4TB, 6TB까지도 늘려보았습니다. 그렇다면 Windows 환경에서는 어떻게 파티션 최대 용량을 늘릴 것인가에 대해서 알아봅시다.

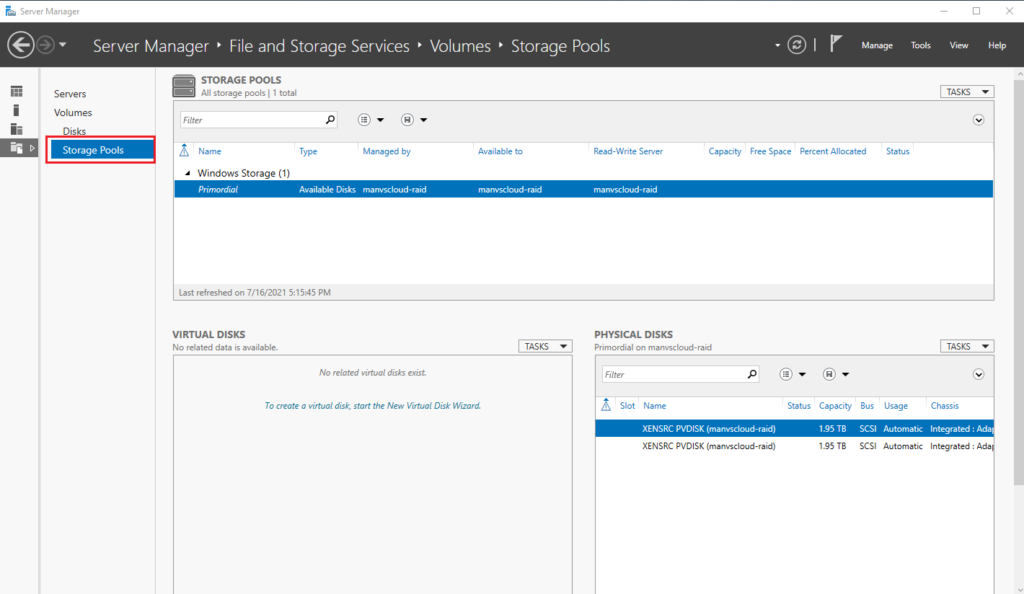

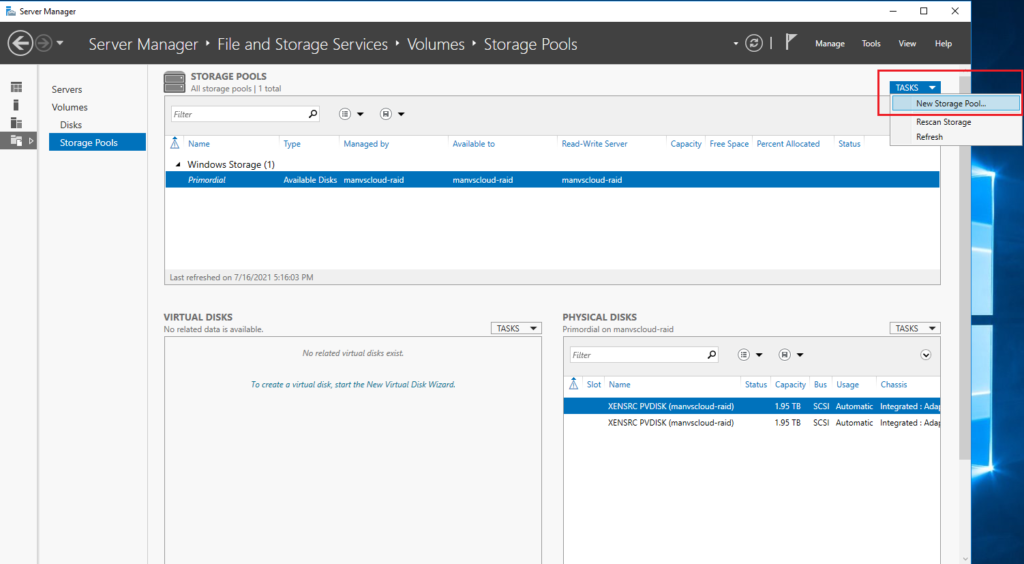

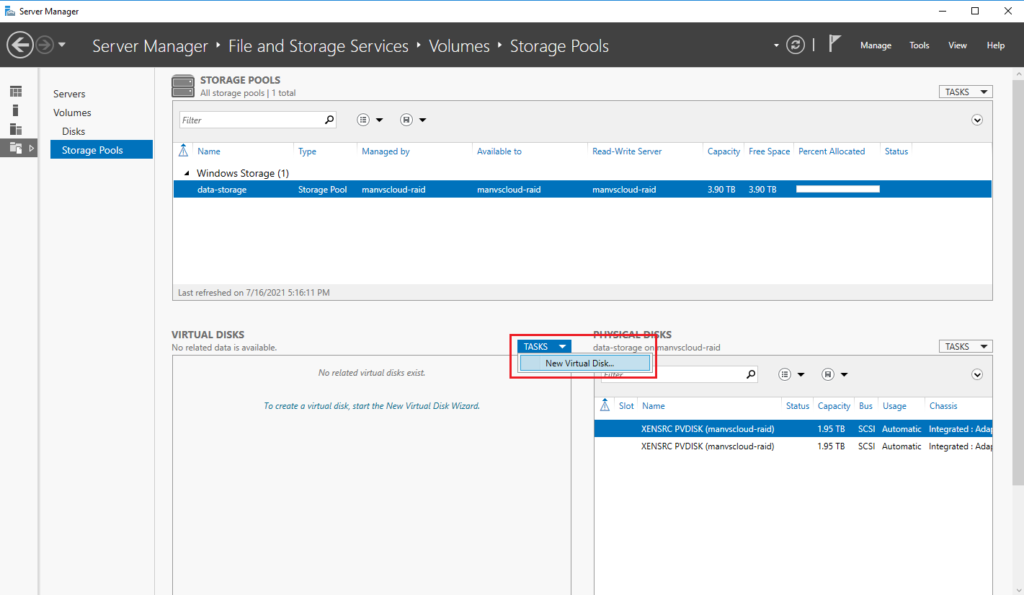

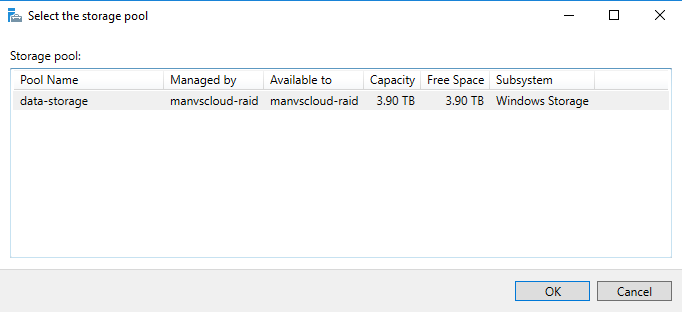

Adding capacity using storage pools

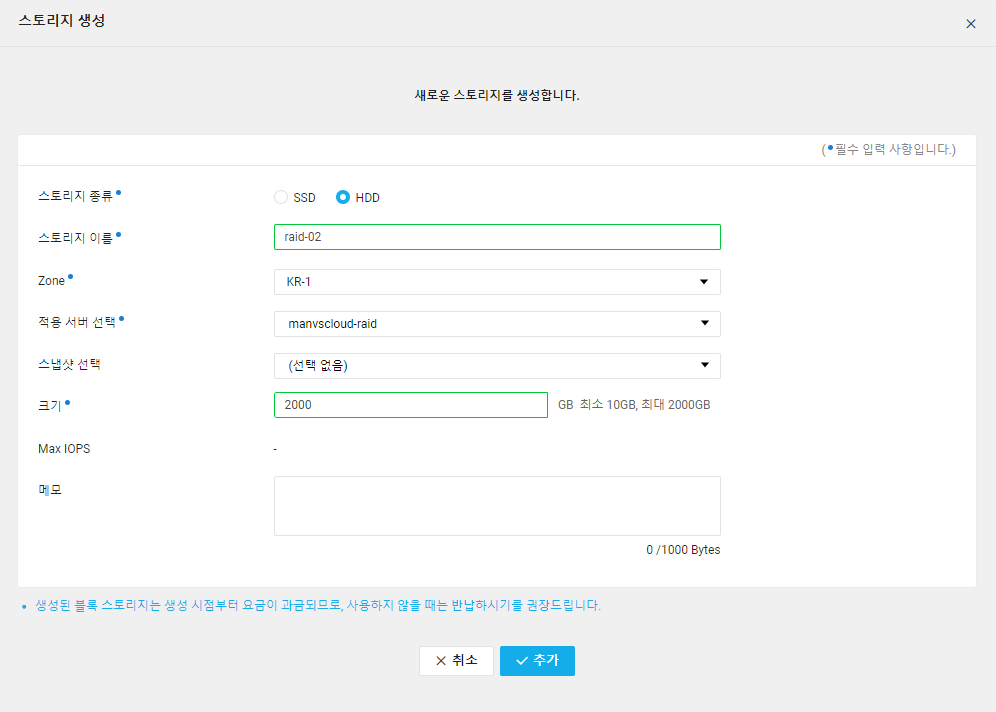

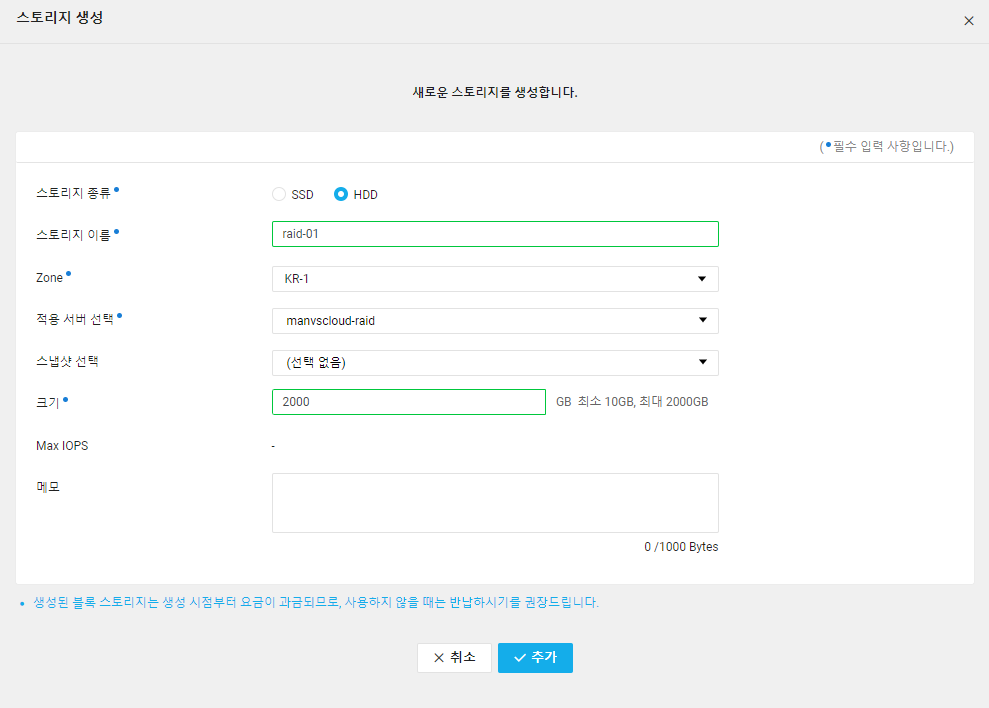

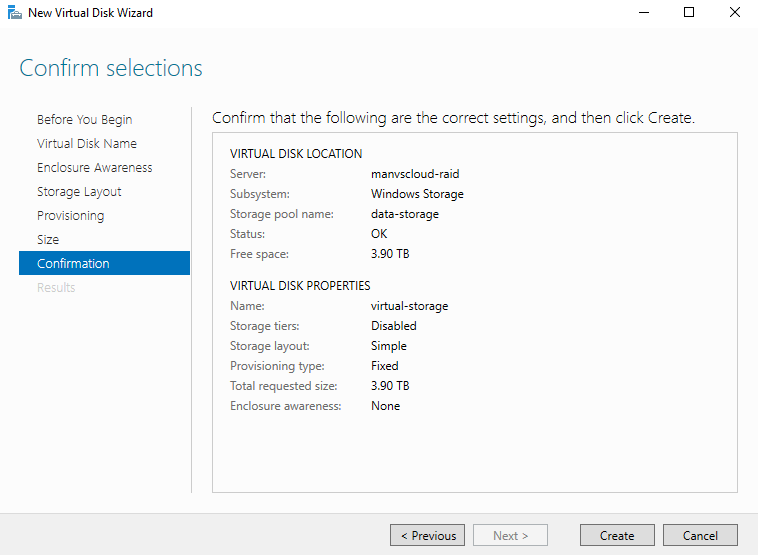

우선 위 이미지와 같이 서버에 추가할 스토리지 2개를 생성합니다.

2000GB 용량으로 2개의 스토리지를 생성해주었습니다.

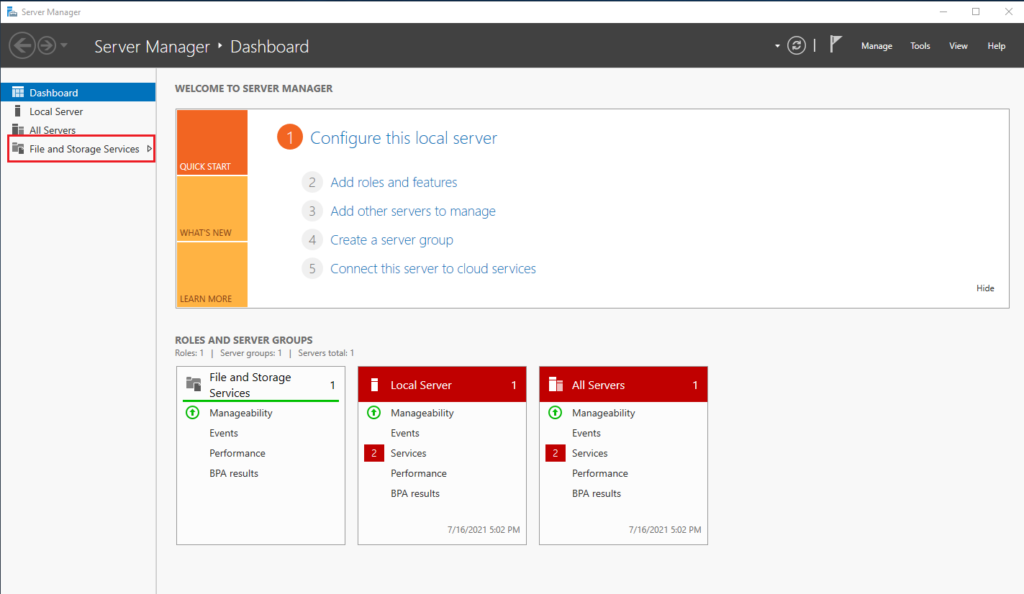

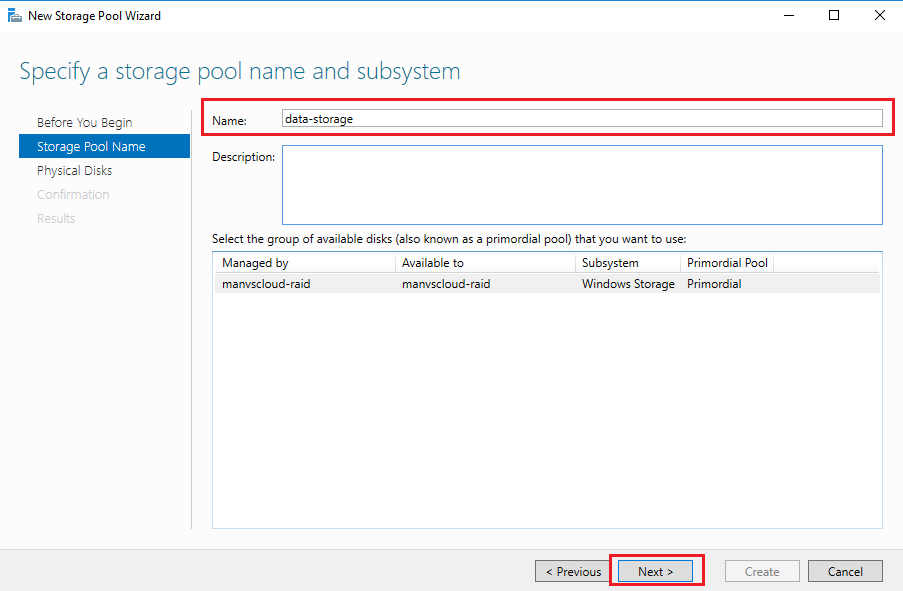

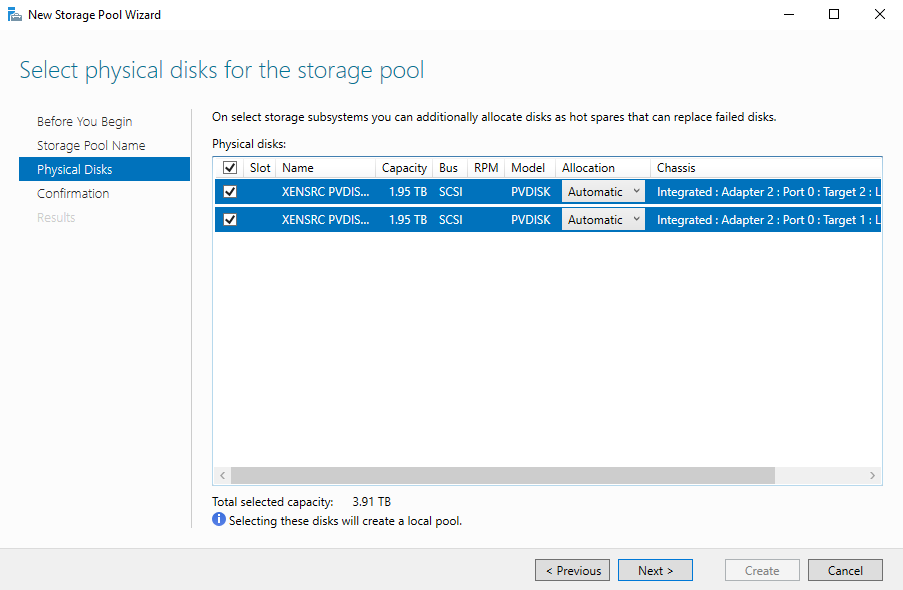

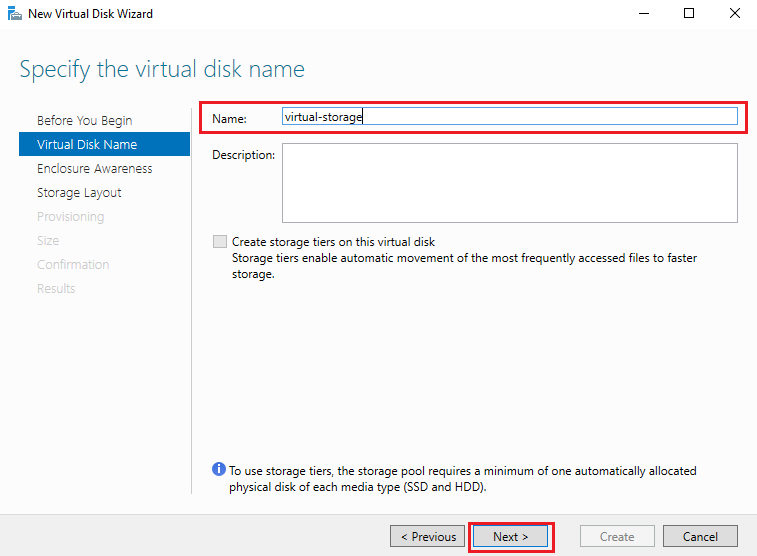

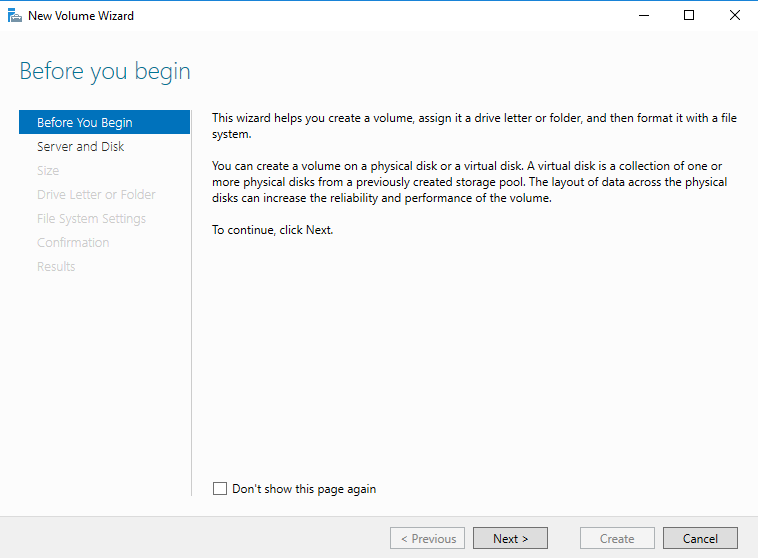

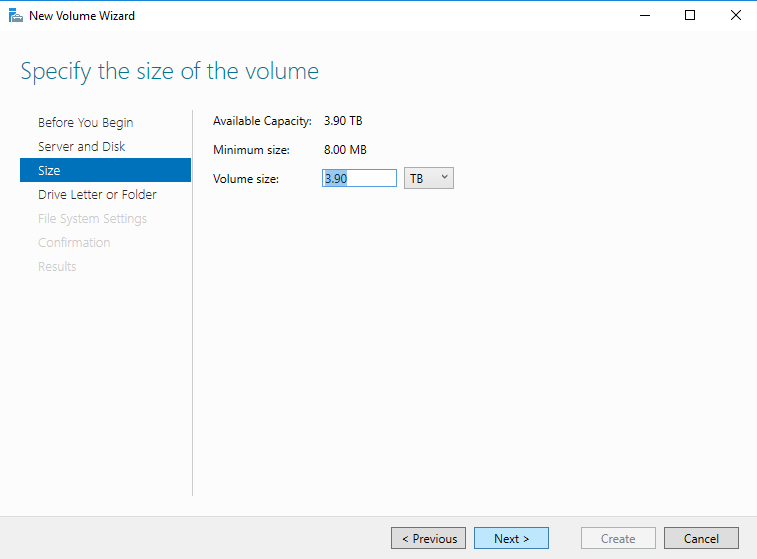

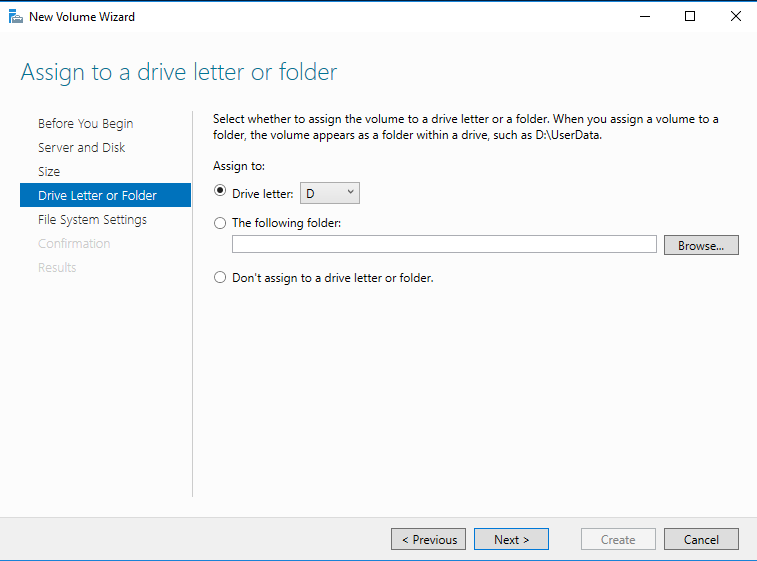

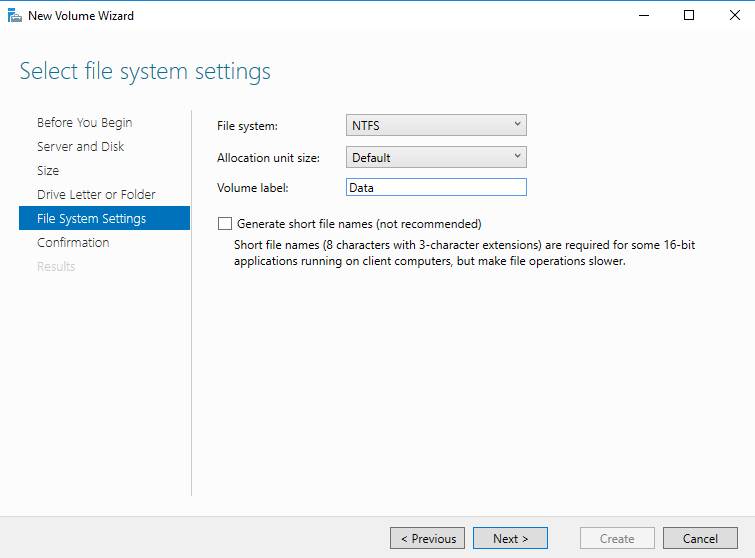

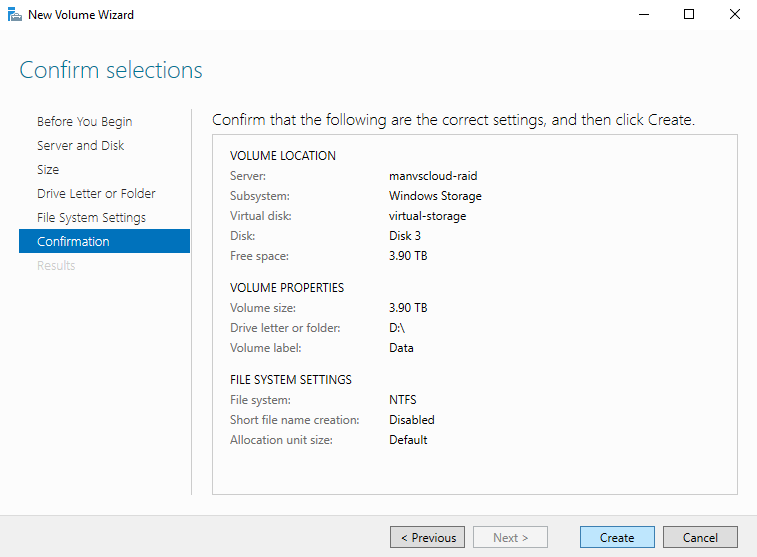

이후 서버에 접속하여 아래 이미지만 순서대로 따라 해주면됩니다.

TIP이라면 중간에 뭔가 잘 안된다 싶으면 F5를 눌러 최신화 해줍시다.

설정한 것이 즉각 최신화가 안돼서 적용하려면 새로고침이 필요하더라구요…

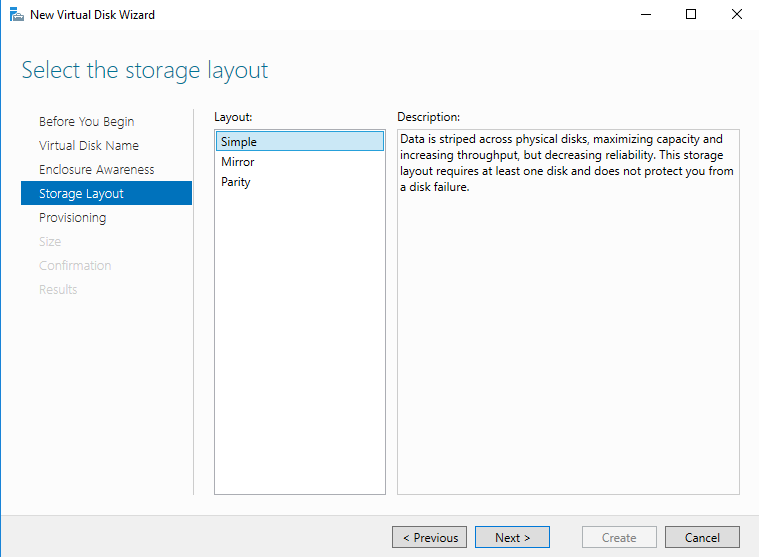

이 부분이 중요한데 Simple이 우리가 아는 RAID 0, Mirror가 RAID 1, Parity가 RAID 5입니다.

RAID에 대한 부분은 따로 설명하지 않으니 RAID가 궁금하실 경우 검색해보시면 자료가 많으니 찾아보시기 바랍니다.

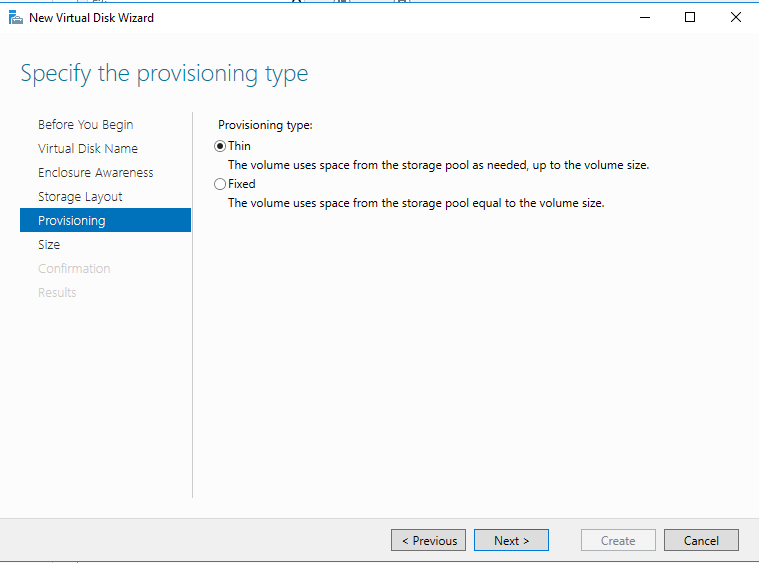

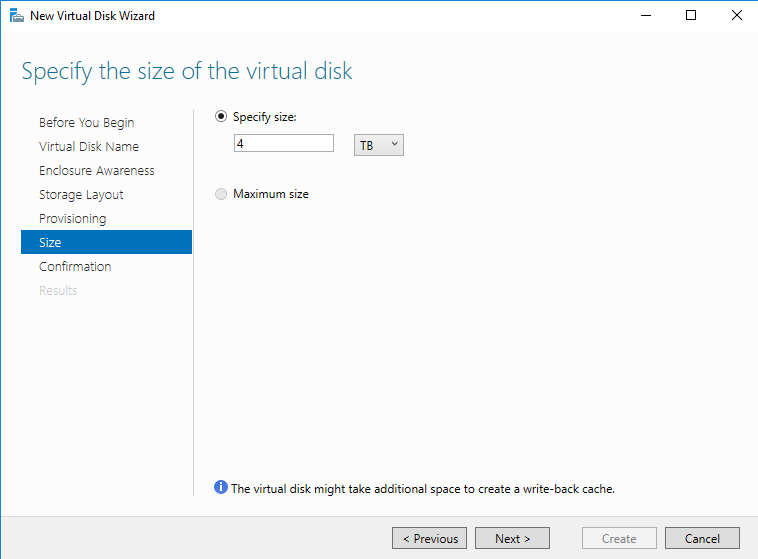

여기서 Thin으로 해줬습니다. Fixed를 해주니 이후에 추가 확장이 정상적으로 되지 않는 증상이 발견되어 Thin으로 선택해주었습니다. 용량이 적을 때는 Fixed로 해도 추가 확장이 잘 되는데 2TB만 넘어가면 추가 확장이 되지 않습니다. 그런데 Thin으로 해주면 이후 2TB가 넘어가도 추가 확장이 가능합니다.

위 작업 후 추가적인 테스트도 진행하였습니다.

RAID 0, RAID 1, RAID 5만 있어서 RAID 10은 RAID 1로 묶어주고 다시 0으로 묶어주는 작업을 해야하나? 싶어서 Storage Pool에서 1로 묶은 뒤 추가적으로 0으로 묶어주려고 했는데 Storage Pool에서는 그렇게 되지 않더라구요.

그런데 이게 diskmgmt.msc (디스크 관리)에서도 Span(JBOD), Simple(RAID 0), Mirror(RAID 1), Parity(RAID 5) 기능이 있단 말이죠?

Storage Pool에서 RAID 1로 묶은 두 디스크가 diskmgmt.msc (디스크 관리)에서 0으로 묶을 수 있길래 재미삼아 한번 해봤는데…

되긴 됩니다.. 그런데 이게 정상적이지는 않아보였습니다.?

디스크 관리에서 RAID 1 디스크 2개를 0으로 추가로 묶어줄 때 12시간이 소요됐습니다.

무려 테스트는 200GB 디스크 4개로 했는데 상당히 오랜 시간이 소요된 것입니다.

이게 과연 정상적일까…?

이렇게 써보신 경험이 있으시다면 댓글로 공유해주세요~

Volume Expansion

자 이제 위에서 구성한 Storage Pool에서 파티션 크기를 더 확장 해보겠습니다.

기존 4TB에서 6TB로 확장하기 위해 스토리지 하나를 더 생성해주었습니다.

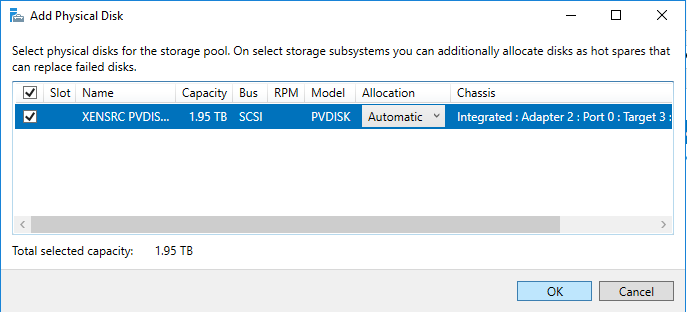

디스크 생성 및 추가 후 Storage Pool에서 위 이미지와 같이 Add Physical Disk를 선택해줍니다. 추가할 Disk가 보이지 않는 다면 F5를 눌러 최신화 해줍시다.

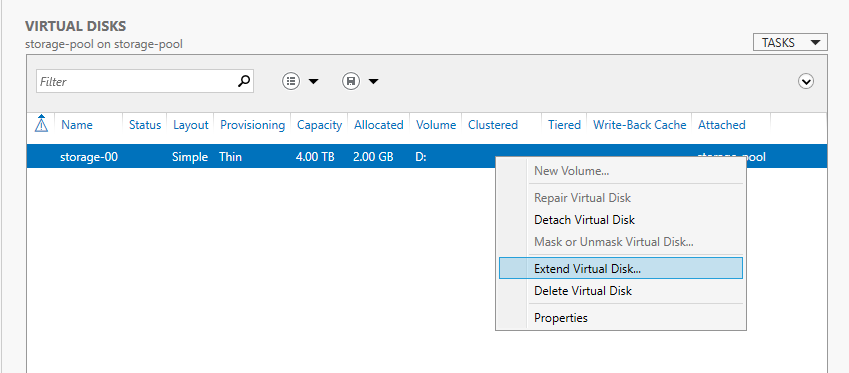

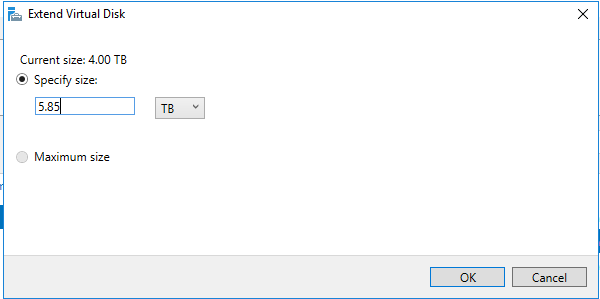

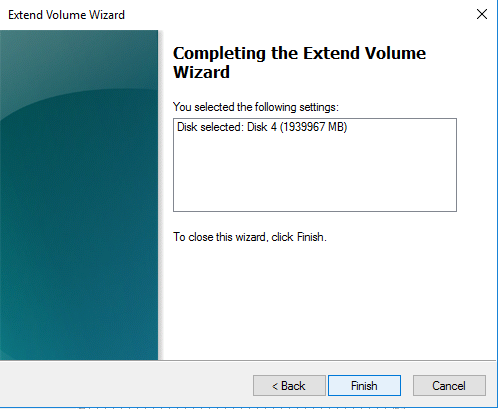

Physical Disk가 정상적으로 추가되면 이제 위 이미지처럼 Virtual Disks에서 Extend Virtual Disk를 선택하여 가상 디스크를 확장해주도록 합시다.

확장할 최대 크기를 입력해줍니다.

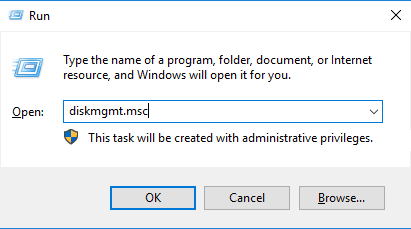

[윈도우 키+ R]을 누르신 후 diskmgmt.msc를 실행하여 디스크 관리를 켜줍니다.

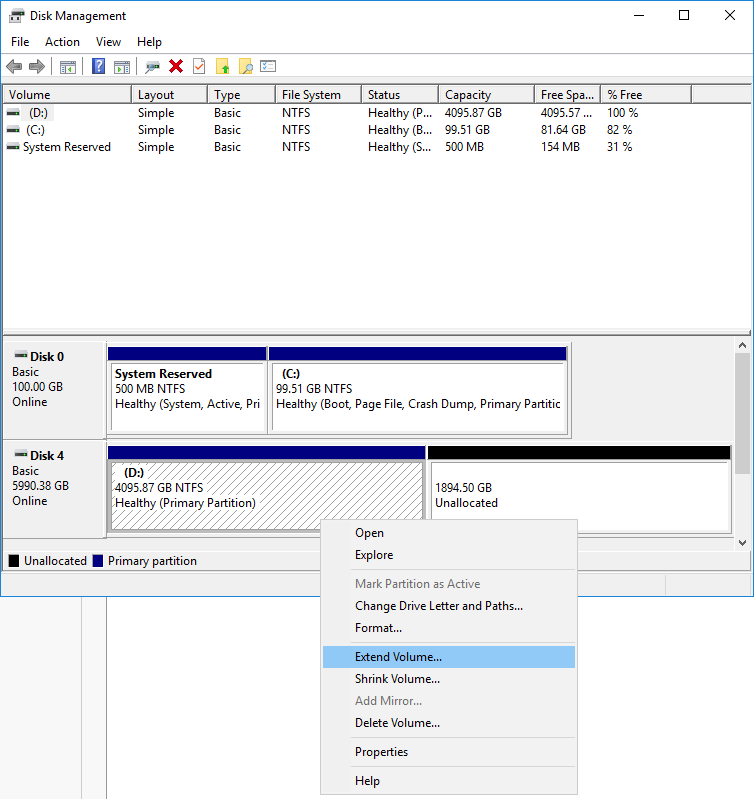

위 이미지처럼 기존 4TB 디스크에서 Extend Volume을 눌러 디스크를 확장해주도록 합시다.

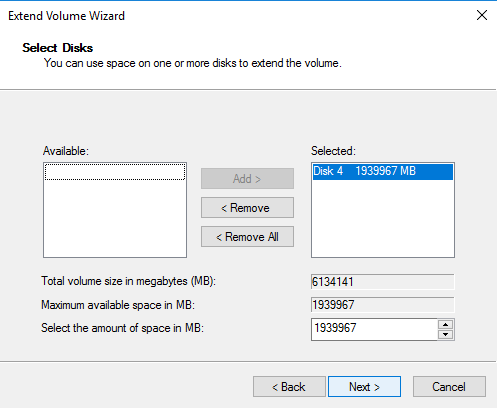

추가한 용량을 선택해주고 Next를 눌러줍니다.

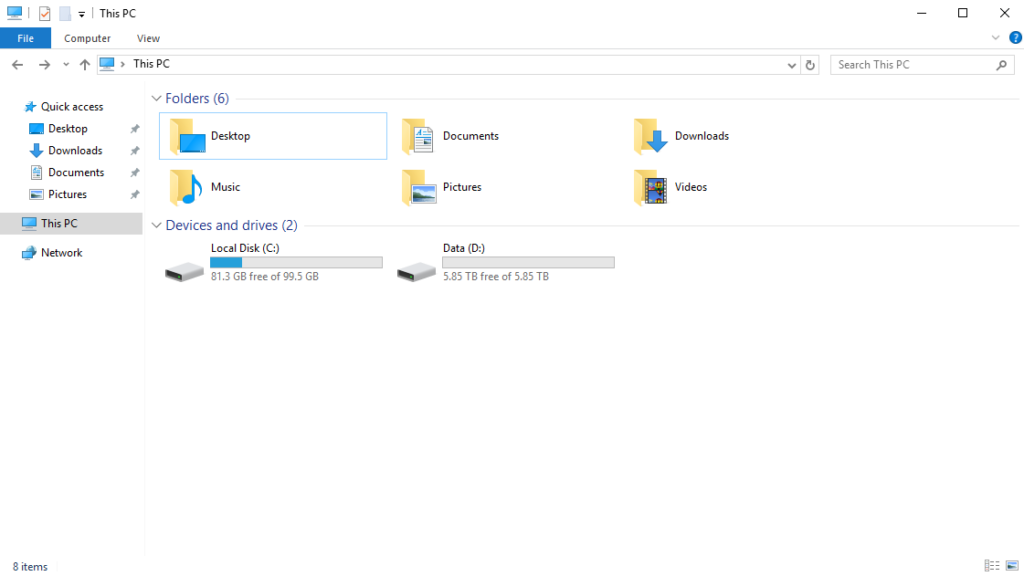

Finish를 눌러 마무리 해주면 아래 이미지와 같이 정상적으로 5.85TB까지 크기가 확장된 것을 확인하실 수 있습니다.

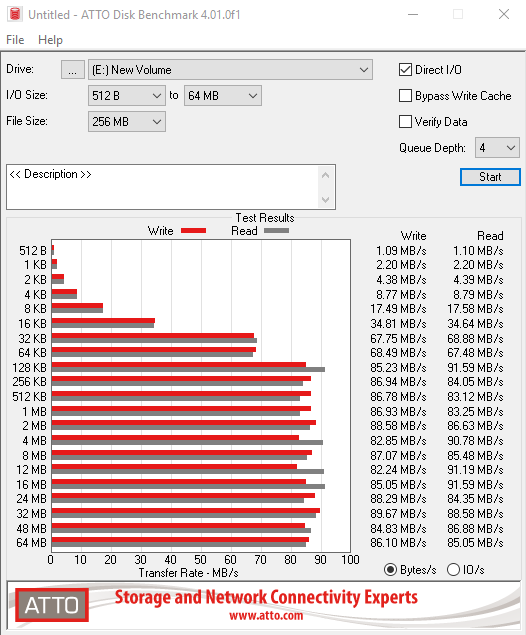

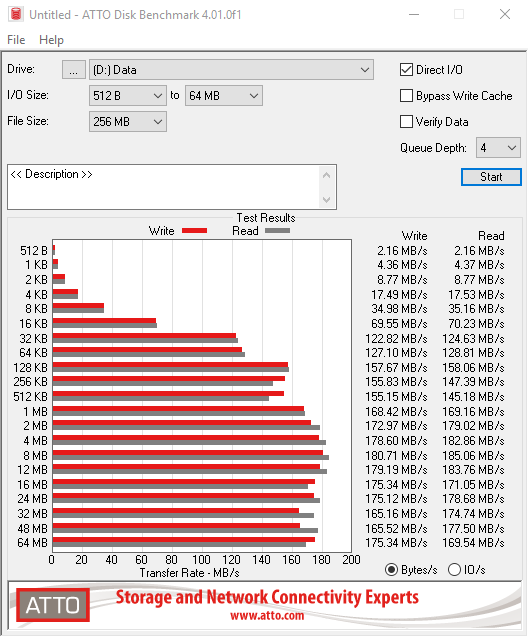

Benchmark performance testing

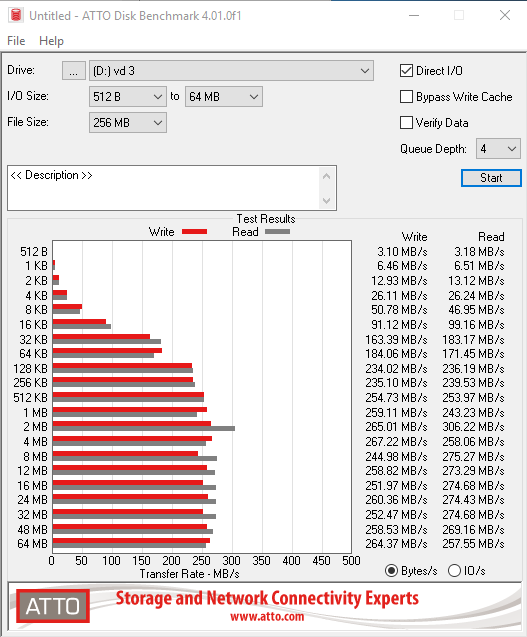

이 포스팅을 준비하면서 Storage Pool을 이용하여 RAID를 묶었을 때 성능 테스트가 궁금해서 벤치마크 성능 테스트도 함께 해보았습니다. 벤치마크 툴은 ATTO Disk Benchmark 를 사용하였습니다.

수치를 보면 확실히 디스크 3개를 RAID 0 으로 묶었을 때가 가장 Write/Read 수치가 높게 나왔습니다. 그런데 이 과정에 재밌는 사실을 하나 알아냈는데 디스크 3개를 RAID 0으로 묶었을 때와 디스크 2개를 RAID 0 으로 묶은 뒤 이후에 추가로 디스크를 1개 더 추가 확장하였을 때 동일한 용량인데 다른 수치를 보였습니다.

디스크 3개를 RAID 0 으로 묶었을 때

: I/O Size 64MB 기준 Write, Read = 264.37, 257.55 MB/s

디스크 2개를 RAID 0 으로 묶고 이후 디스크 1개를 추가 확장했을 때

: I/O Size 64MB 기준 Write, Read = 176.12, 169.78 MB/s

디스크 2개를 RAID 0 으로 묶었을 때

: I/O Size 64MB 기준 Write, Read = 175.34, 169.54 MB/s

RAID를 하지 않았을 때

: I/O Size 64MB 기준 Write, Read = 86.10, 85.05 MB/s

위와 같은 수치가 나왔었습니다.

애초에 처음 RAID를 잡을 때 크게 묶지 않는다면 이후 디스크를 추가하는 부분은 수치가 변하지 않는?…

Note

윈도우 Storage pool 역시 백업을 스냅샷이 아닌 이미지 생성으로 진행해야합니다.

이후 서버에 문제가 생겼을 때 생성된 이미지로 서버를 재생성하면 구성된 Storage pool까지 전부 그대로 올라오는데 스냅샷은 그렇게 되지 않습니다.

단, Linux 편에서도 언급했듯 이미지 백업으로 서버를 생성하면 서버 생성 시 스토리지 종류를 SSD로 선택할 경우 나머지 볼륨들도 전부 SSD로 생성된다는 점!!

OS는 SSD 추가 스토리지를 HDD로 나누어야할 경우 동일하게 서버 생성 후 구성하여 데이터를 복사해줘야합니다.

Personal Comments

여기까지 네이버 클라우드 윈도우 환경에서 2000GB를 초과하는 파티션도 마무리했습니다.

Storage Pool을 이용해서 software RAID를 구성하고 파티션 크기를 확장해보았는데 나름 괜찮은 것같습니다. 원하시는 구성에 맞춰서 RAID 0, RAID 1, RAID5 설정을 하셔서 사용하면 좋을 것같습니다.

긴 글 읽어주셔서 감사합니다.